【本文由小黑盒作者@那个谁的那个谁于08月11日发布,未经许可不得转载!】

之所以想聊一聊这个话题是因为我突然意识到随着半导体工艺的进步(如3nm、2nm甚至更先进制程)和架构的优化(如AMD RDNA/RDNA2/RDNA3+, Intel Xe/Xe²),核显的性能正在显著提升。AMD的Radeon 780M/880M和未来更强的核显已经能流畅运行很多主流网游甚至部分3A大作(在适当画质下),远超过去的核显(当年核显基本只能亮机)

特别是我身边一些对于生产力需求不高的白领女生,她们对于电脑的接触无非就是:日常办公、、看综艺或者看电影、偶尔P照片,这些目前的高端核显都已经绰绰有余了

但是,这也仅限于对于生产力或游戏要求不高的用户

对于绝大部分游戏玩家或者有生产力需求的用户,核显似乎成了累赘

毕竟核显再强,也受限于CPU的TDP封装和散热设计。即使工艺进步,其可用的功耗预算和散热空间也远小于独立显卡(独显通常有100W到600W+的功耗预算)。这也是为什么,现在基本上所有的CPU都提供了无核显版本(更便宜,非常人性化的选择)

所以,在可预见的未来,在性能接近或超越入门级独显(如GTX 1650, RX 6400等)的核显(如AMD的Phoenix/Hawk Point/Strix Point APU上的Radeon 780M/880M/890M),将显著挤压甚至取代这个市场段。用户购买入门级独显的意愿会大大降低

但是在超极本、迷你PC、入门级台式机中,高性能核显将成为绝对主流,满足绝大部分用户的日常和轻度娱乐需求。

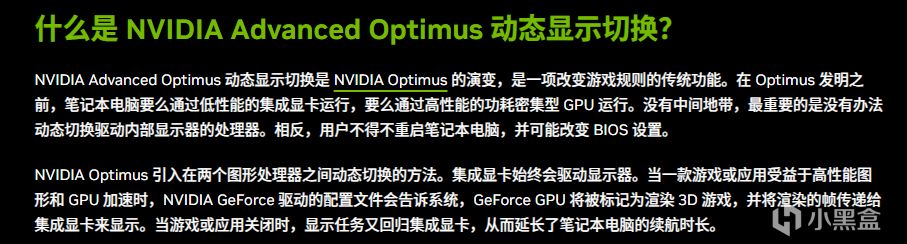

甚至未来可能会有更智能的核显/独显协同工作技术(类似NVIDIA Optimus/AMD SmartShift,但更深入),在低负载时使用核显节能,高负载时无缝切换到独显,甚至协同处理特定任务(如AI加速、物理计算),也许那时候,无核显版本的CPU会退出市场

综上所述,核显和独显将在各自擅长的领域继续发展,形成互补而非替代的关系。核显会越来越强大,成为主流计算设备的标配,而独显则专注于满足高性能和专业计算的需求。“干掉”独显?至少在可预见的未来,这是不可能的。

晋ICP备17002471号-6

晋ICP备17002471号-6